En 1950, Alan Turing, a quien se le considera como uno de los Padres de la IA, escribió «Computing Machinery and Intelligence» en la revista Mind, introduciendo desde aquel entonces una pregunta fundamental que a partir de ese momento daría que hablar sobre el futuro de la inteligencia artificial: ¿Pueden las máquinas pensar? Lo que propuso, ahora conocido como el Test de Turing, estableció un criterio operacional de inteligencia basado en la capacidad de una máquina para mantener una conversación indistinguible de la humana. Hoy, muchos años después, en el 2025, los Modelos de Lenguaje de Gran Escala (LLM) no solo han superado este test en múltiples dimensiones y facetas, sino que han redefinido 360 grados nuestra comprensión de la inteligencia artificial conversacional.

El ecosistema actual de LLM’s presenta una variedad extraordinaria: desde los modelos generalistas como GPT-4o y Claude 3.5 Sonnet, hasta especializaciones técnicas como EXAONE 3.0 de LG AI (así es, la marca de televisores y electrodomésticos ha creado la división de LG AI Research que pone los lineamientos sobre IA en todas las líneas de la marca) para investigación científica, pasando por soluciones open source como LLaMA 3.3 que permiten implementaciones locales y personalizadas (para dar mayor confianza cuando se trabaja con datos sensibles o confidenciales). Este crecimiento ha creado un panorama complejo donde la pregunta ya no es ¿cuál es el mejor modelo para poder usarlo? sino ¿cuál es el modelo correcto para cada caso de uso en específico?

Hoy, en el AI Appreciation Month, desde Capitole les queremos ofrecer un alcance técnico profundo del ecosistema LLM actual, evaluando no solo las capacidades que todo el mundo ya sabe, sino también las limitaciones persistentes (como toda solución tecnológica) y los retos éticos que marcan el futuro de esta tecnología transformadora.

1. La Evolución de los LLMs: De Cajas Negras a Cajas de Herramientas Especializadas

Hasta hace poco, los LLM’s funcionaban como auténticas cajas negras, lo que significa que comprendíamos que en su interior se encontraban sistemas complejos cuyo funcionamiento interno resultaba opaco incluso para sus inventores. La arquitectura transformer, con sus billones de parámetros entrenados con grandes cantidades de datos, generaba resultados sorprendentes sin que pudiéramos entender completamente el funcionamiento de «la magia» que producía dichas capacidades emergentes. Este contexto ha cambiado drásticamente las reglas del juego durante los años 2024-2025. Los LLM’s actuales han avanzado hacia herramientas especializadas con competencias bien documentadas, limitaciones identificadas y casos de uso concretos claramente definidos. La industria y el ámbito de la ciencia y tecnología han fijado normas estandarizadas, métodos de evaluación rigurosos y marcos de interpretación que nos permiten entender no solo las habilidades de estos modelos, sino también su gestión y el motivo por el cual existen.

Esta evolución es palpable en el ecosistema actual: aunque modelos como GPT-4o mantienen su versatilidad universal, hemos notado el surgimiento de especializaciones técnicas como EXAONE 3.0 para investigación científica, Codex para programación, y BioGPT para aplicaciones biomédicas. Según el Informe Stanford AI 2024, el 67% de las implementaciones recientes de LLM’s en empresas optaron por modelos especializados o fine-tuned en lugar de soluciones generalistas, lo que constituye un cambio esencial en las estrategias de adopción de IA.

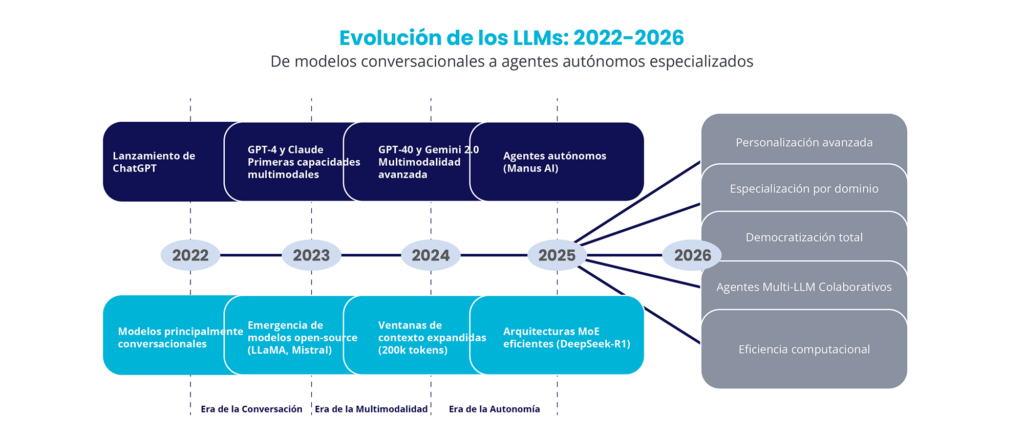

Los LLM’s desde 2022 hasta 2026 nos muestra tres eras claramente distintas:

- La Era del Chat Inteligente (2022-2023) se caracterizó por la inolvidable llegada de ChatGPT y los primeros modelos de conversación, seguida de la aparición de modelos open source como LLaMA y Mistral.

- La Era de la Multimodalidad (2023-2024) presentó las primeras capacidades multimodales con GPT-4 y Claude, ampliando las ventanas de contexto hasta 200K tokens y creando arquitecturas MoE eficaces como DeepSeek-R1.

- Por último, la Era de la Autonomía (2025-2026) señala el cambio hacia agentes autónomos como Manus AI, con tendencias en auge hacia personalización sofisticada, especialización por dominio, democratización total, agentes de colaboración multi-LLM y optimización computacional.

2. Capacidades de Análisis Documental: El Caso de Claude 3.5 y el Contexto Extendido

El análisis de documentos constituye uno de los retos más significativos en los negocios en la actualidad. De acuerdo con él Instituto McKinsey Global, aproximadamente el 19% del tiempo que los trabajadores del conocimiento invierten en la búsqueda y recolección de información, mientras que el estudio de documentos complejos puede requerir entre 40 y 60 horas semanales en áreas como la ley y las finanzas. En sectores muy regulados, como el energético o el farmacéutico, los análisis detallados de la documentación reglamentaria pueden extenderse por meses, necesitando equipos especializados y generando costos operativos considerables. Por ejemplo, Claude 3.5 Sonnet de Anthropic ha transformado este escenario gracias a su amplia ventana de contexto de 200k tokens (similar a aproximadamente 150,000 palabras), la cual facilita la administración de documentos completos sin fragmentación.

Su arquitectura avanzada basada en transformers integra métodos sofisticados de atención y memoria que preservan la consistencia semántica en largos textos, mientras que sus habilidades de razonamiento multimodal facilitan la exploración conjunta de texto, tablas, gráficos y esquemas en documentos complejos. En escenarios de uso reales, Claude 3.5 Sonnet tiene la capacidad de procesar y examinar documentos de hasta 500 páginas en alrededor de 3 minutos, extrayendo información crucial, detectando patrones y produciendo síntesis estructuradas con una precisión del 85 al 92% de acuerdo con benchmarks autónomos. Empresas como Klarna han señalado disminuciones del 75% en el tiempo de análisis de contratos, mientras que organismos jurídicos indican un ahorro de 40 a 60 horas por caso en la revisión de documentación normativa, modificando procedimientos que antes necesitaban equipos de analistas semanalmente.

Estos avances en el análisis inteligente de documentos representan un cambio drástico en el enfoque en que las organizaciones gestionan información abundante. Por ejemplo, Claude 3.5 Sonnet, no solo está incrementando la eficiencia en las operaciones, sino también está democratizando el acceso a análisis de documentos complejos que antes requerían una especialización minuciosa, abriendo la posibilidad que equipos de menor tamaño administren volúmenes de información habitualmente reservados para grandes corporaciones. Aun así, hay que afirmar que sigue siendo crucial reconocer las limitaciones actuales como:

- La exactitud fluctúa en función de la complejidad del dominio.

- Las conclusiones de procesamiento pueden ser relevantes para grandes volúmenes de datos

- La interpretación de los resultados todavía requiere de supervisión humana para garantizar exactitud en momentos críticos.

3. Especialización vs. Versatilidad: Cómo Elegir el LLM Correcto por Caso de Uso

La llegada de LLM’s especializados ha transformado fundamentalmente el paradigma de selección de modelos de IA. A pesar de que en el periodo 2022-2023 la interrogante principal era ¿Cuál es el mejor LLM? El ecosistema presente para el 2025 requiere una visión más sofisticada: ¿Cuál es el modelo perfecto para este caso de uso específico? Esta evolución refleja la madurez del mercado, donde la diferenciación ya no se basa únicamente en competencias globales, sino en la mejora de áreas, funciones y restricciones operaciones específicas.

La selección estratégica de LLM’s requiere una evaluación constante basada en tres dimensiones fundamentales.

- Necesidades técnicas de rendimiento: precisión en parámetros específicos (MMLU para razonamiento general, HumanEval para código y GSM8K para matemáticas), capacidades multimodales y ventana de contexto requerida.

- Parámetros Operativos: latencia de respuesta (tokens por segundo), volumen máximo de transacciones, disponibilidad de APIs y opciones de implementación (cloud vs on-premise).

- Criterios financieros: costo por token, costo total de propiedad, escalabilidad de precios y ROI estimado en función del volumen de uso.

Al aplicar este framework a casos de uso concretos, surgen patrones evidentes de optimización. GPT-4o se destaca en la interacción multimodal con los clientes de términos de razonamiento (MMLU: 87.2%) y habilidades visuales lo que respalda su precio de 5 a 9 dólares por millón de tokens para usos de gran valor. Para un análisis documental, Claude 3.5 Sonnet optimiza la relación entre costo y capacidad con su ventana de 200k tokens y una exactitud del 89% en las tareas de comprensión, de 6 a 12 dólares por millón de tokens. Para implementaciones que manejan datos sensibles, LLaMA 3.3 ofrece un rendimiento competitivo (MMLU:83.6%) con un control total de los datos mediante la implementación local, minimizando los gastos recurrentes tras la inversión inicial en infraestructura.

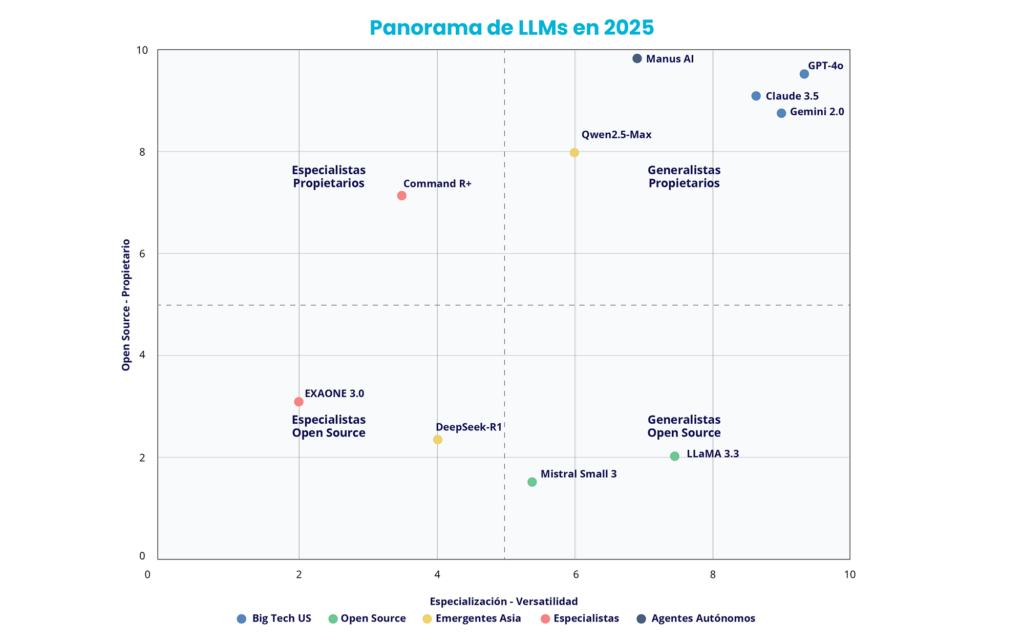

Se nota claramente esta diversificación estratégica en la posición competitiva del ecosistema actual. En la anterior matriz de especialización versus versatilidad (eje horizontal) y modelos de propiedad versus libre acceso (eje vertical), se presentan cuatro cuadrantes distintivos. El panel superior derecho aloja modelos generalistas únicos como GPT-4o, Claude 3.5 Sonnet y Gemini 2.0 Flash, que aumentan la flexibilidad, pero requieren de APIs de naturaleza comercial. El panel inferior derecho ofrece alternativas de fuente libre versátiles como LLaMA 3.3 y Mistral Large, ofreciendo un extenso espectro funcional con un control total sobre la implementación. El panel superior izquierdo presenta soluciones especializadas únicas como Manus AI para agentes autónomos y Command R+ para análisis documental, creadas para casos de uso específicos. Finalmente, la columna inferior izquierda contiene modelos especializados de libre acceso como EXAONE 3.0 para investigación científica y DeepSeek para usos técnicos, fusionando especialización con total transparencia. Esta segmentación corrobora que la elección ideal está sujeta tanto a los requerimientos funcionales particulares como a las limitaciones de apertura, seguridad y control operacional del entorno corporativo.

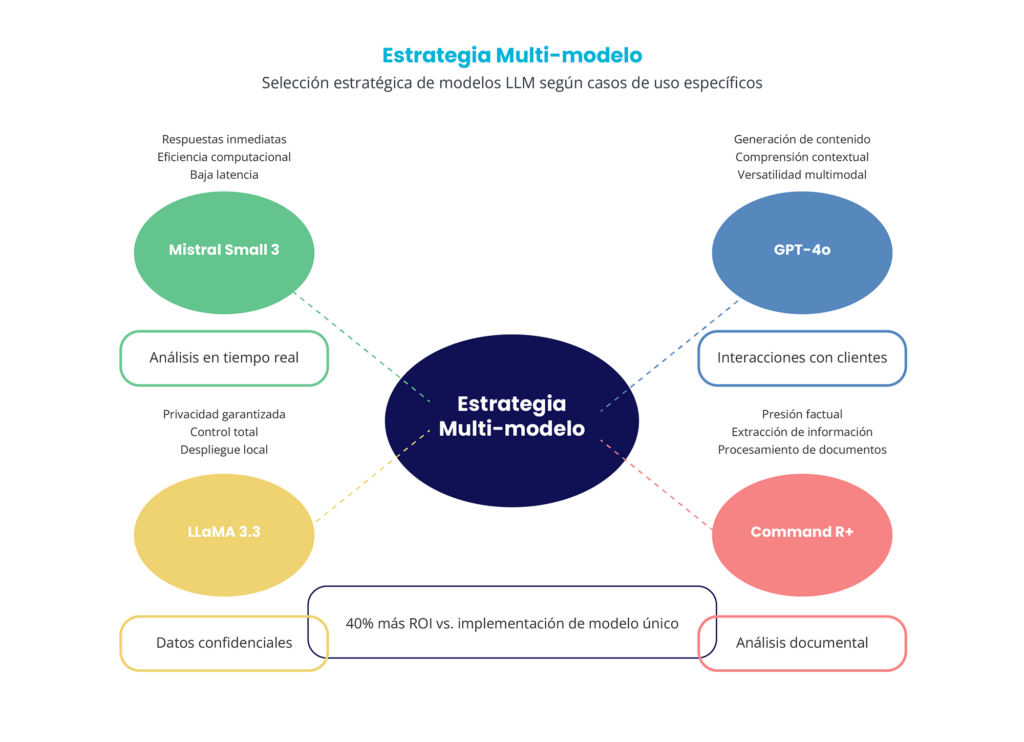

La implementación de esta diversificación ha originado tácticas de diversos modelos que incrementan el retorno de inversión de la empresa. En lugar de apoyarse en un modelo universal, las entidades líderes crean ecosistemas especializados donde cada modelo se optimiza para circunstancias de uso específicas. Por ejemplo, según el gráfico anterior, Mistral Small 3 se centra en la realización de análisis en tiempo real con eficiencia computacional, escasa latencia y respuestas inmediatas. GPT-4o gestiona las interacciones con los clientes mediante la generación de contenido, el análisis del contexto y la capacidad de adaptación multimodal. LLaMA 3.3 asegura la privacidad de datos sensibles con un control absoluto y ejecución local. Command R+ mejora el análisis documental con exactitud factual, obtención de datos y manejo de documentos. Esta estrategia de múltiples modelos produce un 40% más de retorno de inversión en comparación con las implementaciones de un solo modelo, evidenciando que la especialización estratégica sobrepasa la versatilidad universal en entornos corporativos.

Esta técnica de selección fundamentada en pruebas exige un proceso de evaluación estructurado. Primero, es necesario establecer de manera precisa los requerimientos técnicos, operativos y financieros específicos del caso de uso. En segundo lugar, definir indicadores de éxito medibles y límites mínimos de desempeño. En tercer lugar, llevar a cabo ensayos piloto con los aspirantes seleccionados utilizando datasets que representen el ambiente de producción. Finalmente, es necesario calcular el costo total de propiedad previsto para los 12-24 meses, que incluye los gastos de integración, capacitación de equipos y mantenimiento.

Por lo tanto, el principio esencial se mantiene: la optimización estratégica sobrepasa la maximización de capacidades globales, y la elección fundamentada en datos concretos del entorno corporativo.

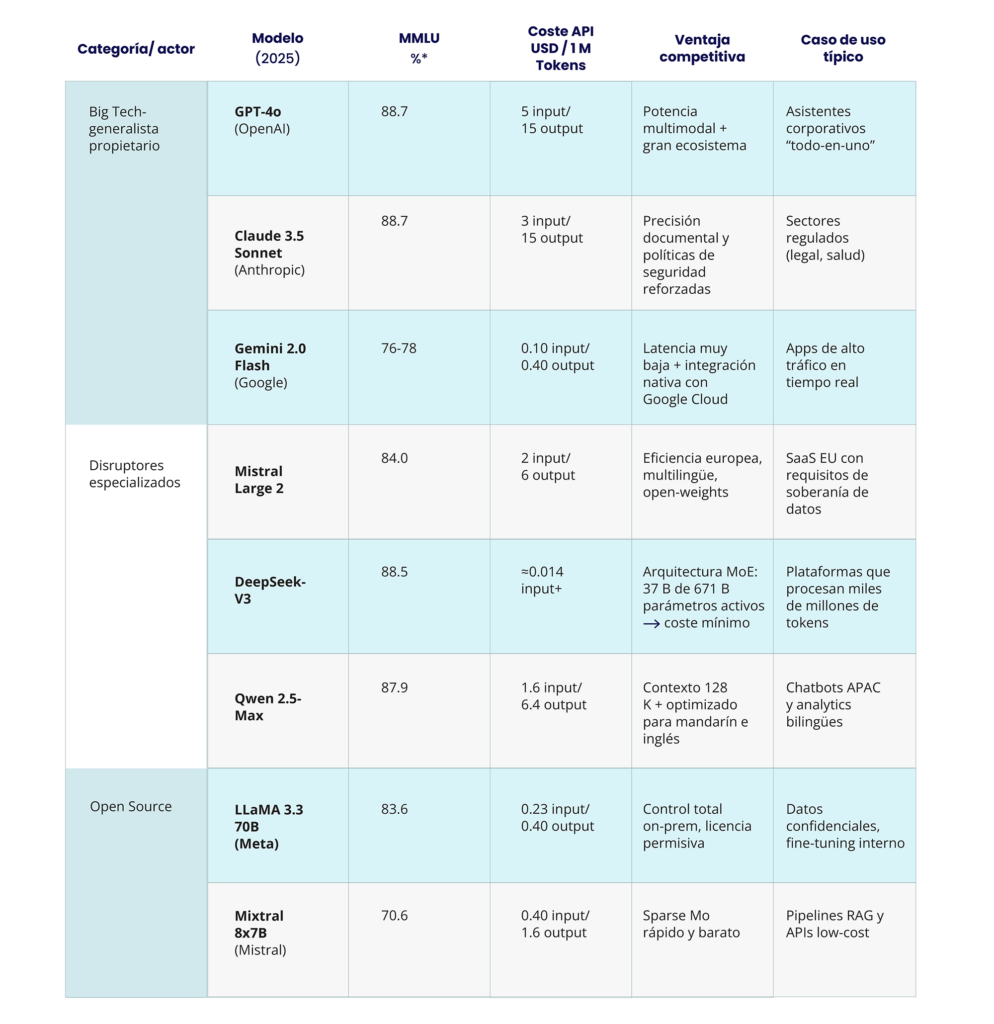

4. Mapeo del Ecosistema: Análisis Comparativo de LLMs Líderes en 2025

En el cuadro de a continuación, hemos tratado de ordenar la tormenta de la IA generativa en el 2025. Se puede ver los gigantes propietarios que marcan el ritmo en la carrera, los disruptores que afinan la relación entre variables de coste y prestaciones y finalmente las opciones open source que democratizan el acceso y control de los datos. Para cada modelo mostramos su nota MMLU (métrica de medición de la comprensión de los LLM), precio por millón de tokens y la ventaja competitiva que lo hace brillar en un caso de uso en específico.

Como se puede observar en la tabla, la elección del LLM más adecuado ya no se basa en establecer el récord Guinness de parámetros, sino en balancear tres aspectos cruciales: el rendimiento real de la tarea, el costo operativo y las necesidades empresariales. Así pues, la estrategia más adecuada suele ser la del multimodal: fusionar tu ejército de batalla apropiado para cada tarea particular y de esta manera incrementar el ROI, la resistencia y la velocidad de iteración.

5. Tendencias 2025-2026: Personalización, Open Source y Agentes Autónomos

Ahora, el panorama se muestra mucho más claro con tres tendencias clave, cada una con consecuencias distintas para su respectiva adopción de negocios.

- La personalización a través de Fine-tuning y RAG se ha transformado en el principal factor de diferenciación competitiva. Empresas como Bloomberg (BloombergGPT), Morgan Stanley (GPT adaptado para el manejo de patrimonio) y Salesforce (Einstein GPT) evidencian que los modelos básicos son únicamente el inicio. El auténtico valor proviene de la adaptación a áreas específicas: fine-tuning para conductas especializadas y RAG para la incorporación de conocimientos de propiedad. De acuerdo con Forrester 2024, el 73% de implementaciones exitosas en empresas contienen algún grado de personalización, con un ROI medio 340% más alto que las implementaciones genéricas.

- La especialización vertical está dividiendo el mercado en modelos optimizados para áreas específicas. Qwen 2.5 controla mercados asiáticos con comprensión cultural nativa, EXAONE 3.0 lidera investigación científica con una precisión del 94% en tareas técnicas, y Harvey AI se especializa en servicios legales con la validación de 200+ compañías a escala global. Esta tendencia sugiere que el futuro se encuentra en modelos que eligen la versatilidad mundial en áreas específicas, creando barreras de entrada tanto técnicas como de datos.

- La democratización de la fuente abierta está impulsando la convergencia de capacidades. LLaMA 3.3 llega al 83.6% en MMLU (en comparación con el 87.2% de GPT-4o), mientras que Mixtral 8x22B iguala modelos de propiedad en tareas concretas. Hugging Face informa sobre 500M+ descargas mensuales de modelos de fuente abierta, lo que señala una adopción en masa. Esta convergencia disminuye las ventajas competitivas fundamentadas en habilidades técnicas tangibles, reorientando la competencia hacia ecosistemas, servicios y especialización horizontal.

El alineamiento de estas tendencias indica un futuro en el que el triunfo de los negocios en Inteligencia Artificial se basará menos en el acceso a modelos sofisticados (que se vuelven cada vez más comodotizados) y más en la habilidad para personalizar, especializar e incorporar estas tecnologías en procesos laborales concretos. Las entidades capaces de ajustar modelos base a sus particulares contextos conservarán ventajas competitivas duraderas

6. Conclusiones: Implementación Estratégica de LLMs en la Empresa

El océano de LLM’s 2025 ha avanzado desde la búsqueda del modelo más adecuado hacia un modelo de optimización estratégica basado en casos de uso específicos. Este progreso demanda una metodología para la selección e implementación de negocios:

- Estructura de decisión definida: El análisis estructurado mediante criterios técnicos (benchmarks específicos), operativos (latencia, throughput, implementación) y económicos (TCO, ROI, escalabilidad) elimina la subjetividad en la selección de los modelos. Las organizaciones que apliquen técnicas basadas en evidencia prevalecerán de forma constante sobre las que se sustentan en la intuición o en las tendencias del mercado.

- Especialización como ventaja competitiva: La fusión de habilidades globales entre modelos de propiedad y de fuente abierta transforma la distinción hacia la especialización vertical y la personalización. El futuro está en manos de las organizaciones que manejen fine-tuning, RAG y la adaptación de modelos base a contextos corporativos singulares, generando obstáculos de entrada basados en datos y experticia específica.

- Democratización y puesta en marcha: La disminución de obstáculos técnicos y financieros simplifica el acceso a habilidades avanzadas de IA, pero potencia la relevancia de la estrategia de implementación. El triunfo de la empresa estará condicionado a la habilidad para incorporar LLM’s en los flujos de trabajo actuales, manejar la transformación organizacional y cultivar habilidades internas de IA.

En Capitole, acompañamos esta transformación traduciendo avances tecnológicos en valor empresarial tangible. La revolución LLM apenas comienza, y las organizaciones que adopten enfoques estratégicos, basados en evidencia y centrados en casos de uso específicos liderarán la próxima década de innovación en IA.